Certificado de finalización de MIT IDSS y 8 Unidades de Educación Continua (CEUs)

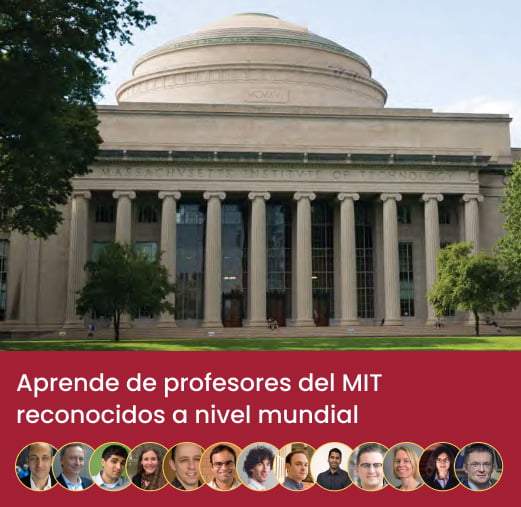

Beneficios de estudiar con el MIT IDSS:

- Certificado de MIT Schwarzman College of Computing y IDSS al completar exitosamente el programa.

- Descuentos exclusivos en cursos online actuales y futuros.

- Suscripción al newsletter del MIT IDSS.

- Notificaciones prioritarias respecto a cursos, programas y eventos.

En el ranking mundial de Universidades

*QS World University Rankings, 2023

En el ranking nacional de Universidades

*U.S News & World Report Rankings, 2023

Nota: La imagen es solo para fines ilustrativos. El certificado real puede estar sujeto a cambios a discreción del MIT IDSS.

Plan de Estudios

+225 horas

de contenido de aprendizaje

+10

Lenguajes y herramientas

El programa de Ciencia de Datos y Aprendizaje Automático: Toma de Decisiones Basada en Datos tiene un plan de estudios cuidadosamente elaborado por profesores del MIT para brindarte las habilidades y el conocimiento para aplicar técnicas de ciencia de datos que te ayudarán a tomar decisiones basadas en datos.

Este programa de certificación profesional de Ciencia de Datos ha sido diseñado para las necesidades de los profesionales de datos que buscan hacer crecer sus carreras y mejorar sus habilidades para resolver problemas comerciales complejos. En un período relativamente corto, el programa tiene como objetivo desarrollar tu comprensión de la mayoría de las tecnologías relevantes de la industria actual.

- Numpy

- Pandas

- Visualización de datos

- Estadística descriptiva

- Estadística inferencial

- ¿Qué es el aprendizaje no supervisado y por qué es un desafío?

- Ejemplos de aprendizaje no supervisado

- ¿Qué es la agrupación?

- ¿Cuándo usar la agrupación?

- K-medias preliminares

- El algoritmo de K-medias

- ¿Cómo evaluar la agrupación?

- Más allá de K-medias: ¿Qué hace un clúster?

- Más allá de K-medias: otras nociones de distancia

- Más allá de K-medias: datos y preprocesamiento

- Más allá de K-medias: big data y bayesiano no paramétrico

- Más allá de la agrupación

- ¿Qué pasa si no tenemos características para describir los datos o no todos son significativos?

- Encontrar los componentes principales en datos y aplicaciones

- La magia de los vectores propios I

- Agrupación en gráficos y redes

- Características de los gráficos: la magia de los vectores propios II

- Agrupamiento espectral

- Agrupación de modularidad

- Incrustaciones: Nuevas características y su significado

- Regresión lineal con una y varias variables

- Regresión lineal para predicción

- Regresión lineal para inferencia causal

- Logística y otros tipos de regresión no lineal

- Cómo hacer buenas predicciones con datos de alta dimensión

- Evitar el sobreajuste mediante validación y validación cruzada

- Regularización por Lasso, Ridge, y su modificación

- Árboles de regresión, bosque aleatorio, árboles potenciados

- Ensayos de control aleatorizados

- Estudios observacionales con confusión

- ¿Qué son las anomalías? ¿Qué es el fraude? ¿Spam?

- Clasificación binaria: falso positivo/negativo, precisión/recuperación, puntuación F1

- Regresión logística y probit: Clasificación binaria estadística

- Prueba de hipótesis: Prueba de razón y valores p de Neyman-Pearson: Confianza

- Máquina de vectores de soporte: clasificador no estadístico

- Perceptron: Clasificador simple con interpretación elegante

- ¿Qué es la clasificación de imágenes? Introducción a ImageNet y ejemplo

- Clasificación utilizando un único umbral lineal (perceptrón)

- Representaciones jerárquicas

- Ajuste de parámetros usando retropropagación

- Funciones no convexas

- ¿Qué tan interpretables son sus características?

- Manipulación de redes profundas (ejemplo de avestruz)

- Transferencia de aprendizaje

- Otras aplicaciones I: Reconocimiento de voz

- Otras aplicaciones II: Procesamiento del lenguaje natural

- ¿Qué hace un sistema de recomendación?

- Entonces, ¿cuál es el problema de predicción de recomendaciones? ¿Y qué datos tenemos?

- Uso de promedios de población

- Uso de comparaciones y clasificaciones de población

- Personalización mediante filtrado colaborativo utilizando usuarios similares

- Personalización mediante filtrado colaborativo utilizando elementos similares

- Personalización mediante filtrado colaborativo utilizando usuarios y elementos similares

- Personalización mediante comparaciones, clasificaciones y elementos de usuario

- Modelo oculto de Markov / Redes neuronales, gráfico bipartito y modelo gráfico

- Usando información secundaria

- Construyendo un sistema: Desafíos algorítmicos y del sistema

- Introducción a las redes

- Ejemplos de redes

- Representación de redes

- Medidas de centralidad: grado, vector propio y rango de página

- Centralidad de cercanía e intermediació

- Distribución de grados, agrupamiento y mundo pequeño

- Modelos de red: Erdos-Renyi, modelo de configuración, apego preferencial

- Modelos estocásticos en redes para la propagación de virus o ideas

- Maximización de la influencia

- Modelos gráficos no dirigidos

- Modelos de Ising y Gaussianos

- Aprendizaje de modelos gráficos a partir de datos

- Modelos gráficos dirigidos

- Estructuras en V, "explicaciones" y modelos gráficos dirigidos al aprendizaje

- Inferencia en modelos gráficos: Marginales y paso de mensajes

- Modelo oculto de Markov (HMM)

- Filtro Kalman

- Ingeniería de predicción

- Introducción

- Tipos de características

- Síntesis profunda de funciones: primitivas y algoritmos

- Síntesis profunda de funciones: apilamiento

- Descripción general de ChatGPT y OpenAI

- Cronología de la PNL y la IA generativa

- Marcos para entender ChatGPT y IA generativa

- Implicaciones para el trabajo, los negocios y la educación

- Modalidades de salida y limitaciones

- Roles comerciales para aprovechar ChatGPT

- Ingeniería inmediata para el ajuste de las salidas

- Demostración práctica y sección extra sobre RLHF

- Fundamentos matemáticos para la IA generativa

- VAE: Primeras Redes Neuronales Generativas

- GAN: generación de imágenes fotorrealistas

- GAN condicionales y difusión estable: control y mejora en la generación de imágenes

- Modelos transformadores: IA generativa para el lenguaje natural

- ChatGPT: IA generativa conversacional

- Creación práctica de prototipos de ChatGPT

- Próximos pasos para un mayor aprendizaje y comprensión

Semanas 1-2: Fundamentos de la ciencia de datos

En las primeras dos semanas, cubriremos los conceptos fundamentales de la ciencia de datos que forman los componentes básicos del curso y te ayudarán a navegar el programa con facilidad.

Python para Ciencia de Datos

1 caso de estudio

Python, para los científicos de datos y los especialistas en aprendizaje automático, es una lengua franca debido a la inmensa promesa de este lenguaje de programación. Para fortalecer tus bases de Python, este módulo se enfoca en NumPy, Pandas y visualización de datos.

Numpy es un paquete de Python para computación científica que permite trabajar con arreglos y matrices multidimensionales.

Pandas es una potente librería de código abierto en Python que se utiliza para analizar y manipular datos.

La visualización de datos significa tratar con la representación gráfica de los datos, lo que genera de manera efectiva información a partir de los datos mediante el uso de librerías matplotlib, seaborn, etc.

Estadística para Ciencia de Datos

1 caso de estudio

El material de esta semana te ayudará a comprender el papel de las estadísticas para ayudar a las organizaciones a tomar decisiones efectivas, conocer sus herramientas más utilizadas y aprender a resolver problemas comerciales mediante el análisis, la interpretación de datos y los experimentos. Verás los siguientes temas:

Te da las medidas fundamentales de un resumen estadístico de los datos.

Explorarás las áreas de distribución y estimación de parámetros, lo que finalmente te permitirá hacer inferencias a partir de los datos.

Semana 3: Dando sentido a los datos no estructurados

En esta semana, aprenderás cómo aplicar diferentes técnicas de AA para descubrir patrones e información en datos no estructurados.

Introducción

Aprenderás sobre uno de los aspectos esenciales de AA: el aprendizaje no supervisado.

Los algoritmos de aprendizaje no supervisado te ayudarán a analizar y agrupar conjuntos de datos no etiquetados. Este capítulo te enseña sobre el aprendizaje no supervisado y los desafíos que se encuentran al usar estos algoritmos.

Este capítulo te hará comprender la implementación de varios algoritmos de aprendizaje no supervisados con ejemplos.

Clustering (Agrupamiento)

2 casos de estudio

La agrupación en clústeres, clustering, es una técnica de aprendizaje no supervisada para agrupar conjuntos similares de puntos de datos. El siguiente módulo del curso de Ciencia de Datos del MIT te presentará las técnicas de agrupación en clústeres ampliamente utilizadas, es decir, la agrupación en clústeres de K-means.

Discutiremos la intuición básica detrás de la agrupación y por qué es frecuente en numerosas industrias.

Este capítulo te enseñará el procedimiento para usar técnicas de agrupamiento.

Este capítulo te ayudará a comprender algunos aspectos preliminares antes de comenzar con el agrupamiento de K-medias.

El algoritmo K-medias en agrupamiento es uno de los algoritmos de aprendizaje no supervisado más comúnmente implementado para resolver problemas de agrupamiento en ciencia de datos o aprendizaje automático.

Este capítulo te familiariza con el procedimiento para evaluar el agrupamiento.

Aprenderás varias técnicas que hacen un clúster.

Este capítulo te familiariza con otros tipos de métodos de distancia en la agrupación y te enseñará los casos de uso de los mismos.

El preprocesamiento de datos es una técnica para limpiar datos sin procesar para usarlos en aplicaciones de aprendizaje automático. Es el paso inicial y más importante al implementar un proyecto de aprendizaje automático.

Este capítulo discutirá por qué el procesamiento previo es necesario para la ciencia de datos y todos los pasos involucrados.

Big data se utiliza para determinar conjuntos de datos grandes y complejos que pueden ser tanto estructurados como no estructurados. Se puede implementar big data para la protección contra fraudes, el aprendizaje automático y el desarrollo de productos.

Un modelo no paramétrico bayesiano es un modelo bayesiano en un espacio de parámetros de dimensión infinita.

En este capítulo, comprenderás todos los temas cruciales más allá de la agrupación en clústeres y sus aplicaciones.

Agrupamiento espectral, componentes e incrustaciones

2 casos de estudio

El agrupamiento espectral es una de las técnicas más ampliamente implementadas para redes y gráficos de agrupamiento. Aprenderás sobre el agrupamiento espectral, de modularidad y el algoritmo PCA. Este módulo discutirá el agrupamiento espectral y sus componentes e incrustaciones.

Este capítulo te enseñará cómo proporcionar una solución si no tienes características para describir los datos o si no todos son significativos.

El análisis de componentes principales es un método para reducir la complejidad de un modelo de aprendizaje automático no supervisado. En términos sencillos, el análisis de componentes principales es como eliminar las variables de entrada de un modelo predictivo para evitar el sobreajuste.

En este capítulo, comprenderás el procedimiento para implementar vectores propios en una matriz.

Obtendrás una comprensión de la agrupación en gráficos y redes.

Comprenderás el procedimiento para implementar vectores propios en una matriz utilizando varias características de los gráficos.

El agrupamiento espectral te permitirá reducir conjuntos de datos multidimensionales complejos en grupos de datos idénticos en dimensiones más raras.

La medida de la fuerza de la división de una red en clústeres se denomina agrupación de modularidad.

Una incrustación es un espacio de dimensión moderadamente baja para traducir vectores de alta dimensión, lo que ayuda a facilitar el aprendizaje automático en entradas enormes.

Semana 4: Descanso de aprendizaje con Masterclass práctica 1

Semana 5: Regresión y Predicción

En esta semana, explorarás los métodos de regresión clásicos y modernos con fines de predicción e inferencia.

Regresión y extensiones clásicas lineales y no lineales

2 casos de estudio

Aprenderás sobre la regresión lineal y no lineal junto con sus extensiones, incluido el caso crucial de la regresión logística para la clasificación binaria y la inferencia causal, donde el objetivo es comprender los efectos de manipular activamente una variable en lugar de medirla pasivamente.

Comprenderás el procedimiento para implementar la regresión lineal con una y varias variables.

En este capítulo te familiarizaras con el procedimiento para implementar la regresión lineal para el análisis predictivo.

Te familiarizaras con el procedimiento para implementar la regresión lineal para la inferencia causal.

La regresión logística es un algoritmo de clasificación simple en aprendizaje automático que predice las variables dependientes categóricas utilizando variables independientes.

Este capítulo te acercará a todos los fundamentos de la regresión logística y otros tipos de regresión no lineal en el aprendizaje automático.

Regresión moderna con datos de alta dimensión

1 caso de estudio

En este módulo aprenderás sobre la regresión moderna con datos de alta dimensión o cómo encontrar una aguja en un pajar. Para grandes conjuntos de datos, se vuelve necesario clasificar qué variables son relevantes para la predicción y cuáles no. Los últimos años han sido testigos del desarrollo de nuevas técnicas estadísticas, como Lasso o Random Forests, que son computacionalmente superiores a grandes conjuntos de datos y seleccionan automáticamente los datos relevantes.

Este capítulo te enseñará el proceso de hacer buenas predicciones con datos de alta dimensión.

El sobreajuste ocurre cuando un modelo sobreentrena los datos. En términos sencillos, supongamos que un modelo aprende los detalles y el ruido dentro de los datos de entrenamiento. En ese caso, los datos de entrenamiento afectarán negativamente el rendimiento del modelo en datos nuevos.

Este capítulo te enseñará el proceso de evitar el sobreajuste a través de técnicas de validación y validación cruzada.

Comprenderás la regularización por Lasso, Ridge y su modificación.

Los árboles de regresión se construyen utilizando particiones recursivas binarias, un proceso iterativo que divide los datos en particiones o ramas. Luego divide cada porción en grupos más pequeños a medida que el proceso avanza en cada rama.

Random Forest, o bosque aleatorio, es un algoritmo predominante de aprendizaje automático supervisado que constituye numerosos árboles de decisión en los innumerables subconjuntos dados de un conjunto de datos. Más tarde, calculará el promedio para mejorar la precisión predictiva del conjunto de datos. El impulso es un metaalgoritmo en Aprendizaje Automático, que transforma clasificadores robustos de varios clasificadores débiles.

La potenciación se puede distinguir como potenciación de gradiente y potenciación adaptativa (ADA).

El uso de la regresión moderna para la inferencia causal

2 casos de estudio

Esta sección cubrirá la regresión y la inferencia causal para explicar por qué "la correlación no implica causalidad" y cómo podemos superar esta limitación intrínseca de la regresión recurriendo a estudios de control aleatorios o controlando la confusión.

Este capítulo te enseñará el proceso de identificar y trabajar con ensayos controlados aleatorios.

La confusión es un riesgo común de la investigación clínica observacional que se opone a los experimentos aleatorios. Sin embargo, puede pasar fácilmente desapercibido, aunque su reconocimiento es esencial para interpretar significativamente las relaciones causales, como evaluar los efectos del tratamiento.

Semana 6: Descanso de aprendizaje con Masterclass práctica 2

Semana 7: Clasificación y Prueba de Hipótesis

En esta semana, aprenderá sobre los conceptos básicos de detección y clasificación de anomalías y los fundamentos de la prueba de hipótesis, que es la formalización de la investigación científica. Esta delicada configuración estadística obedece a un conjunto específico de reglas que se explicarán y pondrán en contexto con la clasificación.

Prueba de hipótesis y clasificación

1 caso de estudio

En este módulo del programa de certificación MIT en Ciencia de Datos, aprenderás pruebas de hipótesis y varios algoritmos de clasificación. La prueba de hipótesis es una técnica para realizar experimentos utilizando los datos observados/encuestados. Como su nombre lo indica, la clasificación es una técnica para clasificar un conjunto de datos en diferentes categorías y se puede realizar tanto en datos estructurados como no estructurados.

Las anomalías ocurren cuando las bases de datos se planifican de manera inadecuada y no están normalizadas, donde todos los datos se almacenan en una tabla. El fraude, como su nombre indica, es un acto fraudulento sin autorización. El spam es una comunicación digital no solicitada, como el envío de mensajes, correos electrónicos, etc., a una gran cantidad de personas con fines comerciales.

En este capítulo, comprenderás el procedimiento para detectar anomalías, fraudes y filtrar spam en aprendizaje automático.

La clasificación binaria es una técnica de aprendizaje automático supervisado, donde las categorías están predefinidas y clasificadas en nuevas observaciones probabilísticas. Cuando hay dos categorías, se llama clasificación binaria.

La regresión probit es un método en el que la variable dependiente toma solo dos valores. Este capítulo discutirá todos los conceptos esenciales, como la regresión logística, la regresión probit y la clasificación binaria estadística.

Obtendrás una comprensión de todos los conceptos críticos de la prueba de hipótesis.

Support Vector Machine, abreviado como SVM, es otro algoritmo de aprendizaje automático popular que se utiliza para problemas de regresión y clasificación.

Un perceptrón es una neurona artificial, o simplemente, un modelo matemático de una neurona biológica. Este capítulo te familiariza con el perceptrón y sus diversos conceptos.

Semana 8: Descanso de aprendizaje con Masterclass práctica 3

Semana 9: Aprendizaje Profundo

El aprendizaje profundo,o Deep Learning, se ha convertido en una fuerza impulsora en la revolución tecnológica en curso. La esencia del Deep Learning radica en su capacidad para imitar al cerebro humano en el procesamiento de datos para varios propósitos, también sin supervisión humana. Las redes neuronales están en el corazón de esta tecnología. Esta semana te llevará más allá del aprendizaje automático tradicional y al ámbito de las redes neuronales y el aprendizaje profundo. Aprenderás cómo el aprendizaje profundo se puede aplicar con éxito a áreas como visión computarizada y más.

Aprendizaje profundo

1 caso de estudio

Los alumnos comprenderán todos los conceptos críticos del aprendizaje profundo, como la clasificación de imágenes, la propagación hacia atrás, el aprendizaje por transferencia, la PNL, el reconocimiento de voz y mucho más.

La clasificación de imágenes es un concepto fundamental en el aprendizaje profundo. Identifica objetos en una imagen entrenando un modelo a través de la experimentación con imágenes etiquetadas.

Este capítulo te enseñará el proceso de identificación de objetos en una imagen y te presentará ImageNet, junto con varios ejemplos.

Aprenderás el proceso de implementación de técnicas de clasificación utilizando un único umbral lineal (perceptrón).

Aprenderás el proceso de representación de modelos de aprendizaje profundo en una estructura jerárquica.

En este capítulo, aprenderás cómo encontrar coeficientes (parámetros) para uno o varios modelos para ajustar datos.

Este capítulo te familiariza con las funciones de optimización no convexas en el aprendizaje profundo.

Comprenderás cómo se pueden interpretar las características.

Comprenderás el proceso de manipulación de redes neuronales profundas utilizando el ejemplo del avestruz.

El aprendizaje por transferencia es un enfoque de aprendizaje profundo ampliamente implementado. Es un modelo desarrollado para una aplicación que puede ser reutilizado como punto inicial de un modelo en una segunda aplicación.

El reconocimiento de voz es una técnica para transformar el habla humana en texto escrito mediante el reconocimiento de la voz de un individuo.

El procesamiento del lenguaje natural (NLP) es una técnica para aplicar la lingüística computacional para construir aplicaciones del mundo real, que funcionan con lenguajes que comprende varias estructuras. Aquí, intentamos enseñarle a una computadora a aprender idiomas y luego esperamos que la computadora analice y comprenda estos idiomas usando algoritmos adecuados y eficientes.

Semana 10: Sistemas de recomendación

A medida que las organizaciones se inclinan cada vez más hacia los enfoques basados en datos, la comprensión de los sistemas de recomendación puede ayudar no solo a los expertos en ciencia de datos, sino también a los profesionales en otras áreas, como el marketing, que también se espera que sean alfabetizados en datos hoy. Conoce por qué los sistemas de recomendación ahora están en todas partes y obtén información sobre lo que se requiere para crear un sistema de recomendación adecuado cubriendo el modelado estadístico y los algoritmos.

Recomendaciones y Clasificación

1 caso de estudio

Los algoritmos del sistema de recomendación, en pocas palabras, sugieren elementos relevantes a los usuarios, explicando las tendencias de su uso en una variedad de industrias y su papel central en la generación de ingresos.

Como su nombre lo indica, los sistemas de recomendación ayudan a predecir la preferencia futura de cualquier producto y recomendar los artículos más adecuados para los usuarios.

En este capítulo, comprenderás el procedimiento para utilizar un sistema de recomendación para elegir los mejores productos para los usuarios.

La técnica en la que el sistema predice si a un individuo o a una empresa le gusta el producto (un problema de clasificación) o las reseñas o calificaciones de ellos (un problema de regresión) se conoce como problema de predicción de recomendación.

Comprenderás el procedimiento para usar promedios de población.

Comprenderá el procedimiento para usar comparaciones y clasificaciones de población.

Filtración colaborativa

1 caso de estudio

El filtrado colaborativo es un aspecto de los sistemas de recomendación con el que interactuamos con bastante frecuencia. Al recopilar datos sobre las preferencias de múltiples usuarios, el filtrado colaborativo hace predicciones para la elección de un usuario en particular.

Comprenderás el procedimiento para utilizar el filtrado colaborativo con la ayuda de usuarios similares.

Comprenderás el procedimiento para utilizar el filtrado colaborativo con la ayuda de elementos similares.

Comprenderás el procedimiento para utilizar el filtrado colaborativo con la ayuda de usuarios y elementos similares.

Recomendaciones personalizadas

1 caso de estudio

Como sugiere el propio nombre, las recomendaciones personalizadas funcionan para filtrar las recomendaciones que son personalmente relevantes para un usuario, en función de sus tendencias de navegación, etc.

Aprenderás cómo utilizar recomendaciones de personalización con la ayuda de comparaciones, clasificaciones y elementos de usuario.

El modelo oculto de Markov (HMM) es un modelo estadístico de Markov en el que el sistema que se modela se considera un proceso de Markov con estados ocultos/no observados.

Te familiarizarás con el procedimiento para usar información adicional con la ayuda de Meta-Prod2Vec.

Te familiarizarás con el procedimiento para crear un sistema considerando los desafíos algorítmicos y del sistema.

Semana 11: Redes y Modelos Gráficos

En esta semana, obtendrás una descripción general sistemática de los métodos para analizar redes grandes, determinar estructuras importantes en dichas redes e inferir datos faltantes en las redes. Se pone énfasis en los modelos gráficos, tanto como una forma poderosa de modelar procesos de red como para facilitar el cálculo estadístico eficiente.

Introducción

En este módulo del curso de Ciencia de Datos del MIT, conocerás qué son las redes y cómo podemos representarlas con sus casos prácticos de uso que nos rodean.

Se puede definir una red como un grupo de dos o más sistemas informáticos vinculados mediante varios componentes de hardware, como concentradores, conmutadores y más.

En este capítulo, obtendrás una comprensión de todos los ejemplos de redes.

Este capítulo te familiarizará con el procedimiento para representar redes.

Redes

1 caso de estudio

En este módulo del programa, aprenderás sobre las medidas descriptivas estándar de una red, como centralidad, cercanía e intermediación, y modelos estocásticos estándar para redes, como Erdos-Renyi, conexión preferencial, modelos de infección, nociones de influencia, etc.

Este capítulo te familiarizará con el procedimiento para implementar medidas de centralidad, como grado, vector propio y rango de página.

Obtendrás una comprensión de la centralidad de la cercanía y la intermediación.

Obtendrás una comprensión de la distribución de grados, la agrupación y el mundo pequeño.

El modelo Erdos-Renyi te ayuda a crear redes o gráficos aleatorios en las redes sociales. El modelo de configuración es una técnica para generar redes aleatorias a partir de una secuencia de grados dada. El apego preferencial es un método en el que los nuevos miembros de la red intentan establecer una conexión con los miembros existentes más frecuentes.

Obtendrás una comprensión de los modelos estocásticos en las redes para la propagación de virus o ideas.

El problema de identificar un pequeño subconjunto de nodos (nodos semilla) en una red social que pueda maximizar la difusión de la influencia se denomina maximización de la influencia.

Modelos gráficos

1 caso de estudio

Aprenderás a usar modelos gráficos para estimar y mostrar una red de interacciones.

En este capítulo, aprenderás acerca de los modelos gráficos no dirigidos.

El modelo de Ising especifica la distribución de probabilidad conjunta de un vector para comprender las transiciones de fase. Un modelo gaussiano es una distribución normal bidimensional de la concentración en las direcciones vertical y de viento cruzado centrada alrededor del eje a favor del viento desde el punto inicial.

Obtendrás una comprensión de varios modelos gráficos de datos.

Un modelo gráfico dirigido se refiere a la probabilidad de variables aleatorias en un producto de probabilidades condicionales, disponible para cada nodo en el gráfico.

Comprenderás más acerca de los modelos gráficos dirigidos, las estructuras en V y la "explicación".

Este capítulo te enseñará acerca de la inferencia en modelos gráficos, como los Marginales y el paso de mensajes.

En este capítulo repasamos tu conocimiento previo del Modelo Oculto de Markov (HMM).

El algoritmo de filtro de Kalman se utiliza para proporcionar estimaciones de algunas variables desconocidas, dado que las mediciones se observan durante un período particular.

Semana 12: Análisis predictivo

En esta semana, aprenderás sobre algunos ejemplos prácticos de fuentes de datos temporales y cómo podemos comenzar a comprenderlos. Luego, te sumergirás en varias estrategias para la extracción de características, incluida la síntesis profunda de características con primitivas y apilamiento. Finalmente, buscarás modelos para el mundo real y cómo asegurarte de que predicen con éxito datos futuros.

Modelado predictivo para datos temporales

1 caso de estudio

El modelado predictivo es la técnica de utilizar resultados anteriores para crear, procesar y validar un modelo, que eventualmente se puede usar para hacer predicciones futuras. Aprenderás sobre la estructura de los datos temporales y cómo podemos definir claramente las entradas y salidas de entrenamiento para la predicción.

La ingeniería de predicción es la técnica de generar ejemplos de entrenamiento a partir de datos existentes para entrenar un modelo de aprendizaje automático para futuras predicciones.

Ingeniería de características

1 caso de estudio

Sabrás cómo utilizar técnicas de ingeniería de características para extraer información significativa de datos temporales; ¿Cuáles son las estrategias efectivas para evaluar el rendimiento del modelo y prepararse para implementarlo en el mundo real?

Este capítulo introducirá a los alumnos a la ingeniería de características, una técnica para transformar datos desde el estado sin procesar a un estado apropiado para el modelado. Ayuda a transformar las columnas de datos en características que representan mejor una situación dada en términos de claridad.

Te familiarizarás con tres tipos de características: cuantitativas, ordinales y categóricas.

Deep Feature Synthesis, abreviado como DFS, es un proceso automatizado que ejecuta la ingeniería de características en datos relacionales y temporales.

Este capítulo te enseñará acerca de las primitivas y los algoritmos involucrados en DFS.

Este capítulo te enseñará cómo apilar en DFS.

Módulos de auto-aprendizaje

Módulo 1 - Desmitificando ChatGPT y Aplicaciones

El módulo cubre:

Módulo 2 - ChatGPT: Stack de desarrollo

El módulo cubre:

Certificado de finalización de MIT IDSS

Al completar con éxito el programa, recibirás uno de los mejores certificados profesionales en Data Science, ya que será del MIT Institute for Data, Systems, and Society (IDSS).

Cuota del programa

Cuota del programa:

USD 2,500

Paga con plazos diferidos

Comienza tu camino pagando la cuota de admisión de 300 USD

Paga el resto en pagos mensuales sin intereses

Pago por adelantado y referencia

USD 2,300

USD 2,350

Beneficios de aprender con nosotros

- Clases grabadas con profesores del MIT

- 2 módulos de autoaprendizaje sobre ChatGPT y IA generativa

- Mentoría en vivo con expertos en ciencia de datos y machine learning

- 3 proyectos relevantes para la industria y +50 casoa de estudio

- Coordinador de Programa de Great Learning para dudas académicas y no académicas

Fecha de inicio de la siguiente edición

Online

Por anunciar

Edición cerrada

En colaboración con:

Este programa se imparte en colaboración con Great Learning. Great Learning es una empresa de educación con un impacto global en más de 170 países. Su misión es contribuir al desarrollo profesional de personas en todo el mundo y prepararlas para el futuro. Great Learning colabora con el MIT IDSS y provee expertos en la industria, coordinadores de programa, apoyo durante el programa para asegurar que los estudiantes obtengan aprendizaje práctico y mentoría en vivo personalizada con aplicación de los conceptos enseñados por los profesores del MIT IDSS.